La evolución de los sistemas operativos ha estado marcada por la búsqueda de arquitecturas que puedan gestionar la creciente complejidad del software. Los sistemas operativos por capas y, en particular, las arquitecturas de micronúcleo, representan un esfuerzo por estructurar los sistemas de manera más modular y manejable. Este enfoque contrasta con los primeros sistemas operativos monolíticos, que carecían de una estructura definida y donde cualquier procedimiento podía llamar a cualquier otro, lo que se volvía insostenible a medida que crecían en tamaño y funcionalidad.

El diseño por capas ya buscaba organizar las funciones jerárquicamente, con interacciones limitadas a capas adyacentes. Sin embargo, incluso en estos, persistían problemas como el exceso de funcionalidad por capa y la dificultad para personalizar o asegurar el sistema debido a las interacciones complejas. Es aquí donde la arquitectura de micronúcleo propone una solución más radical.

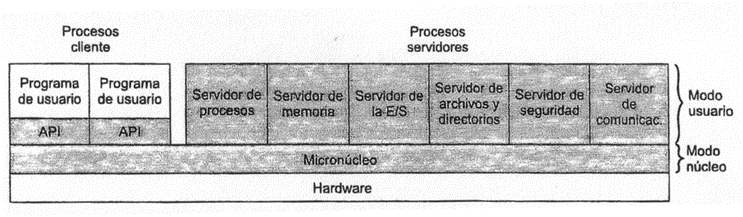

La filosofía de un micronúcleo (o microkernel) es mantener en el núcleo del sistema operativo solo las funciones absolutamente esenciales. El resto de los servicios, que tradicionalmente formaban parte del sistema operativo, se implementan como subsistemas externos o servidores que se ejecutan en modo usuario. Esta pequeña parte central proporciona la base para extensiones modulares.

Aunque la filosofía de qué se incluye y qué se excluye del micronúcleo puede variar entre diseños, un conjunto mínimo de funciones y servicios que un micronúcleo debe incluir se centra en aquellas que dependen directamente del hardware y las necesarias para mantener a los servidores y aplicaciones operando en modo usuario. Estas funciones generalmente se agrupan en las siguientes categorías:

- Gestión de memoria a bajo nivel: Responsable de los aspectos más básicos de la administración de la memoria.

- Comunicación entre procesos (IPC – Interprocess Communication): Proporciona el mecanismo fundamental para que los procesos o hilos se comuniquen entre sí, típicamente a través de mensajes. Un mensaje incluye una cabecera que identifica al remitente y al receptor, y un cuerpo con datos, un puntero a un bloque de datos, o información de control.

- Gestión de E/S y manejo de interrupciones: Reconoce las interrupciones hardware y las transforma en mensajes que se envían a procesos de nivel de usuario asociados, delegando el manejo específico del dispositivo fuera del micronúcleo.

- Gestión básica de procesos: Incluye la planificación de procesos y la gestión fundamental de los mismos.

En una arquitectura de micronúcleo, los componentes del sistema operativo que no están en el micronúcleo se implementan como procesos servidores que operan en modo usuario. Estos servidores interactúan entre sí, generalmente mediante el paso de mensajes a través del micronúcleo. Así, el micronúcleo actúa como un intercambiador de mensajes, validándolos, pasándolos entre componentes y concediendo acceso al hardware. También ejerce una función de protección, impidiendo el paso de mensajes a menos que el intercambio esté permitido.

Por ejemplo, si una aplicación necesita abrir un archivo, envía un mensaje al servidor de archivos. Si quiere crear un proceso o hilo, envía un mensaje al servidor de procesos. Estos servidores, a su vez, pueden comunicarse con otros servidores o invocar funciones primitivas del micronúcleo. Esto establece una arquitectura de tipo cliente/servidor dentro de un solo computador.

La organización de micronúcleo ofrece varias ventajas significativas para el diseño y mantenimiento de sistemas operativos:

- Interfaces Uniformes: El micronúcleo impone una interfaz uniforme para todas las solicitudes. Los procesos no necesitan diferenciar entre servicios a nivel de núcleo y a nivel de usuario, ya que todos se proporcionan mediante paso de mensajes.

- Extensibilidad: Facilita la adición de nuevos servicios y la realización de múltiples servicios en la misma área funcional sin requerir la modificación o recompilación de todo el núcleo. Los cambios en un servidor se restringen a un subconjunto del sistema.

- Flexibilidad: No solo se pueden añadir nuevas características, sino que las existentes pueden eliminarse para crear implementaciones más pequeñas y eficientes. Esto hace que el sistema operativo sea adaptable a diversas necesidades, ya que las características sustanciales pueden ser opcionales.

- Portabilidad: Gran parte del código específico del procesador se concentra en el micronúcleo. Esto simplifica la adaptación del sistema a nuevas arquitecturas de procesadores, ya que los cambios necesarios son menores y están lógicamente agrupados.

- Fiabilidad: Un micronúcleo más pequeño es más fácil de verificar rigurosamente. Al tener un número limitado de interfaces de programación de aplicaciones (API), es más sencillo producir código de calidad para los servicios del sistema operativo que se ejecutan fuera del núcleo. Un fallo en un servidor no necesariamente corrompe o detiene el resto del sistema.

- Soporte de Sistemas Distribuidos: El micronúcleo facilita el soporte para sistemas distribuidos, incluyendo clusters. Un proceso puede enviar un mensaje a un servicio sin necesidad de saber en qué máquina reside, creando una imagen única del sistema a nivel de micronúcleo.

- Soporte de Sistemas Operativos Orientados a Objetos (OOOS): La arquitectura de micronúcleo se alinea bien con el diseño orientado a objetos, permitiendo personalizar el sistema operativo sin comprometer su integridad y facilitando la creación de herramientas y sistemas distribuidos orientados a objetos.

A pesar de sus beneficios, una desventaja potencial de los micronúcleos es el rendimiento. El tiempo que lleva construir, enviar un mensaje a través del micronúcleo y procesar la respuesta es mayor que una simple llamada a un servicio local. Esto se debe a la sobrecarga de la comunicación entre procesos (IPC), que implica cambios de contexto, cambios de modo y el uso de búferes de memoria adicionales.

Los estudios iniciales con micronúcleos de primera generación revelaron pérdidas de rendimiento sustanciales. Para mitigar esto, algunos diseños optaron por hacer los micronúcleos más grandes, reintroduciendo servicios críticos y manejadores en el núcleo, lo que reducía los cambios de modo usuario-núcleo y de espacio de direcciones. Sin embargo, esto sacrificaba parte de la fortaleza del diseño de micronúcleo, como la mínima interfaz y la flexibilidad.

Un enfoque posterior, con micronúcleos de segunda generación (como L4), se centró en hacerlos aún más pequeños. Con un código de solo 12 Kbytes y 7 llamadas al sistema (en contraste con 300 Kbytes y 140 llamadas de la primera generación), las experimentaciones indicaron que estos sistemas podían funcionar tan bien o mejor que sistemas operativos por capas como UNIX, eliminando muchas de las pérdidas de rendimiento.

La arquitectura de micronúcleo se integra perfectamente con el paradigma de la computación cliente/servidor, que es cada vez más relevante en los sistemas de información y redes.

La computación cliente/servidor implica la interacción entre:

- Clientes: Generalmente PCs o estaciones de trabajo que proporcionan una interfaz de usuario amigable (por ejemplo, con interfaces gráficas como Windows o Macintosh) y ejecutan aplicaciones.

- Servidores: Máquinas más potentes (estaciones de trabajo, minicomputadores, mainframes) que almacenan información y proporcionan servicios compartidos a los clientes, como bases de datos relacionales.

- Red: El elemento esencial que interconecta a clientes y servidores, distribuyendo usuarios, aplicaciones y recursos a través de LAN, WAN o Internet.

Este modelo se distingue por su énfasis en aplicaciones fáciles de usar en el cliente y la capacidad de distribuir tareas entre cliente y servidor para optimizar el rendimiento y la facilidad de uso.

Para que clientes y servidores se comuniquen en un entorno distribuido, se utilizan principalmente dos mecanismos:

- Paso de Mensajes (Message Passing): Un proceso cliente envía un mensaje de solicitud de servicio a un proceso servidor, y este último realiza la petición y envía un mensaje con la respuesta. Las operaciones mínimas son

send(enviar) yreceive(recibir). Los mensajes pueden ser de longitud fija o variable, incluyendo una cabecera con información de control (tipo, origen, destino, longitud). El direccionamiento puede ser directo (especificando el proceso destinatario) o indirecto (usando buzones o puertos, lo que permite relaciones uno-a-uno, uno-a-muchos, muchos-a-uno o muchos-a-muchos). - Llamadas a Procedimiento Remoto (RPC – Remote Procedure Call): Permite que dos programas en máquinas diferentes interactúen utilizando la sintaxis y semántica de llamadas a procedimiento locales. El programa llamante ejecuta una llamada de procedimiento normal con parámetros, y un stub local se encarga de empaquetar la llamada y enviarla a través de la red al servidor. El servidor procesa la llamada y devuelve el resultado, haciendo que la interacción sea transparente al programador como si fuera una llamada local. Las RPC tradicionales son síncronas (bloqueantes), aunque también pueden ser asíncronas.

En entornos cliente/servidor, el middleware es un conjunto de interfaces de programación y protocolos estándares que se sitúa entre las aplicaciones y el sistema operativo/software de comunicaciones. Su propósito es ocultar la complejidad y las disparidades de los diferentes protocolos de red y sistemas operativos, permitiendo a los desarrolladores construir aplicaciones que accedan a recursos del sistema de manera uniforme a través de diversas plataformas. Esto facilita la interoperabilidad y la capacidad de combinar productos de diferentes proveedores.

Microsoft Windows, desde Windows 2000 en adelante (incluyendo XP y Server 2003), implementa una arquitectura que Microsoft denomina micronúcleo modificado. No es un micronúcleo puro, pero adopta muchos de sus principios para lograr modularidad y flexibilidad.

En Windows, el software del sistema operativo se divide entre el modo usuario y el modo núcleo (o kernel mode). El modo núcleo tiene acceso completo a los datos del sistema y al hardware, mientras que el modo usuario tiene acceso limitado. Los componentes clave que se ejecutan en modo núcleo incluyen:

- Sistema Ejecutivo (Executive System): Contiene servicios básicos del sistema operativo como gestión de memoria, gestión de procesos e hilos, seguridad, E/S y comunicación entre procesos (IPC).

- Núcleo (Kernel): La parte más fundamental, gestiona la planificación de hilos, el intercambio de procesos, las excepciones, el manejo de interrupciones y la sincronización multiprocesador. Es la única parte no expulsable o paginable del sistema operativo.

- Gestor de E/S: Proporciona el entorno para que las aplicaciones accedan a dispositivos de E/S, enviando peticiones a los controladores apropiados y proveyendo seguridad y nombrado para dispositivos y sistemas de archivos.

- Gestor de Caché: Mejora el rendimiento de E/S basada en archivos, manteniendo datos recientemente referenciados en memoria principal y retrasando escrituras en disco.

- Gestor de Objetos: Crea, gestiona y elimina objetos del sistema ejecutivo de Windows (como procesos, hilos, objetos de sincronización), estableciendo reglas uniformes para su control, nombrado y seguridad.

- Gestor de Plug and Play: Determina y carga los controladores necesarios para un dispositivo.

- Monitor de Referencia de Seguridad: Se encarga de la validación de acceso y la generación de auditorías.

- Utilidad de Llamada a Procedimiento Local (LPC – Local Procedure Call): Fuerza una relación cliente/servidor entre aplicaciones y subsistemas ejecutivos dentro de un único sistema, de forma similar a las RPC para procesamiento distribuido.

La razón para ejecutar muchas funciones fuera del micronúcleo en modo núcleo es el rendimiento, ya que una arquitectura de micronúcleo pura requeriría numerosos intercambios entre procesos/hilos, cambios de modo y uso de búferes adicionales.

Windows se apoya considerablemente en el diseño orientado a objetos para facilitar la compartición de recursos y la protección. Conceptos clave incluyen:

- Encapsulación: Un objeto agrupa atributos (datos) y servicios (procedimientos). El acceso a los datos solo es posible invocando uno de los servicios del objeto, protegiéndolos de usos no autorizados.

- Clases e Instancias de Objetos: Una clase es una plantilla que define atributos y servicios. El sistema operativo crea instancias específicas de una clase cuando las necesita (por ejemplo, un objeto de proceso por cada proceso activo).

- Herencia: Los objetos contenidos pueden heredar propiedades del objeto contenedor (aunque a nivel de usuario, esto no es directamente visible).

- Polimorfismo: Windows utiliza un conjunto común de funciones para manipular objetos de diferentes tipos.

El sistema ejecutivo, los subsistemas protegidos y las aplicaciones de Windows se estructuran según un modelo cliente/servidor. Cada subsistema de entorno (como Win32, Posix, OS/2) y subsistema del servicio ejecutivo se implementa como uno o más procesos. Los clientes (aplicaciones o módulos del SO) solicitan servicios enviando mensajes, que son enrutados por el sistema ejecutivo al servidor apropiado. El servidor realiza la operación y devuelve la información de estado mediante otro mensaje.

Las ventajas de esta arquitectura interna cliente/servidor incluyen:

- Simplificación del ejecutivo: Permite construir diversas API sin conflictos.

- Mejora de la fiabilidad: Cada módulo de servicio se ejecuta como un proceso separado con su propia partición de memoria protegida, de modo que el fallo de un servidor no provoca el fallo de todo el sistema operativo.

- Comunicación uniforme y flexible: Las aplicaciones utilizan LPC para comunicarse con el ejecutivo, y los stubs de funciones ocultan el paso de mensajes.

- Base para la computación distribuida: Un servidor local puede enviar mensajes a un servidor remoto para procesar peticiones, siendo transparente para el cliente si la petición se atiende local o remotamente.

Aunque Linux se describe como un núcleo monolítico —integrando la mayoría de las funcionalidades del sistema operativo en un gran bloque de código que ejecuta en un único proceso con un único espacio de direcciones—, logra muchas de las ventajas de la modularidad mediante una arquitectura particular.

Linux está estructurado como una colección de módulos cargables que pueden enlazarse y desenlazarse dinámicamente con el núcleo en tiempo real. Un módulo implementa funciones específicas como sistemas de archivos, controladores de dispositivos o características de la capa superior del núcleo. Estos módulos se ejecutan en modo núcleo en nombre del proceso actual, pero no como procesos o hilos propios. Esta modularidad facilita la configuración, reduce el uso de memoria del núcleo y permite añadir o eliminar funciones sin necesidad de reiniciar todo el sistema, lo que es una ventaja significativa en el desarrollo y mantenimiento.

En resumen, la arquitectura de micronúcleo y el modelo cliente/servidor interno de sistemas como Windows, así como la modularidad lograda por sistemas como Linux, demuestran diversas estrategias para gestionar la complejidad y proporcionar flexibilidad, fiabilidad y eficiencia en los sistemas operativos modernos.